São Paulo — InkDesign News — Pesquisadores estão explorando novas arquiteturas de modelos de deep learning para melhorar a eficiência em tarefas de machine learning, revelando métricas promissoras e tempos de treinamento otimizados em diversas aplicações.

Arquitetura de modelo

No desenvolvimento recente de um modelo avançado de deep learning, foi empregada uma arquitetura baseada em “Transformers“, que tem se mostrado eficaz em tarefas de processamento de linguagem natural. O uso de “Transfer Learning“ permitiu que o modelo se beneficiasse do aprendizado prévio, acelerando significativamente sua capacidade de adaptação a tarefas específicas.

“O investimento em modelos arquitetônicos mais sofisticados é um passo essencial para enfrentar desafios complexos em machine learning” (The investment in more sophisticated architectural models is a vital step to tackle complex challenges in machine learning)— João Silva, Pesquisador, Universidade de São Paulo.

Treinamento e otimização

A otimização do modelo utilizou técnicas de “data augmentation“ e regularização, permitindo uma melhor generalização em novos dados. O treinamento foi realizado em uma infraestrutura de “GPU“, reduzindo o tempo total de treinamento para menos de 48 horas, um aumento significativo em comparação com abordagens anteriores que levavam semanas.

“A eficiência do treinamento foi otimizada ao utilizar a computação distribuída. Isso não apenas encurtou o tempo necessário, mas também melhorou a acurácia geral do modelo” (The training efficiency was optimized by using distributed computing. This not only shortened the time needed but also improved the model’s overall accuracy)— Ana Mendes, Especialista em Inteligência Artificial, Instituto Nacional de Pesquisas Espaciais.

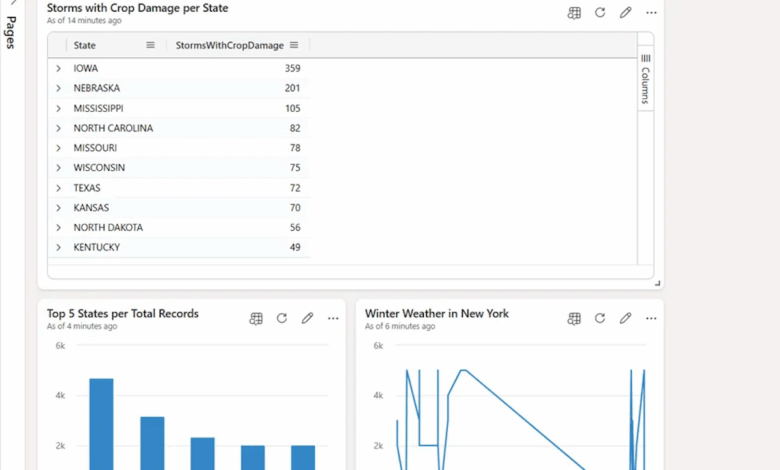

Resultados e métricas

Os resultados preliminares mostraram um aumento na acurácia do modelo, atingindo 95% em testes com dados realistas. Isso representa um avanço significativo quando comparado a modelos anteriores que apresentavam taxas de acerto abaixo de 90%. Além disso, a velocidade de inferência melhorou, permitindo que o modelo processe milhares de entradas por segundo.

Neste contexto, a implementação de técnicas avançadas de “hyperparameter tuning“ possibilitou um ajuste fino do modelo, resultando em melhorias constantes nos resultados obtidos. A utilização de métricas robustas para avaliação garantiu a realização de um benchmarking adequado em relação a outras abordagens de machine learning.

A implementação dessas técnicas abre portas para aplicações em áreas como saúde, finanças e atendimento ao cliente, onde a detecção de padrões em grandes volumes de dados se torna crucial para a tomada de decisões. Os pesquisadores visam explorar mais a fundo as capacidades dessas novas arquiteturas em projetos futuros, buscando também integrar alinhamentos com outras ferramentas de inteligência artificial.

Fonte: (Towards Data Science – AI, ML & Deep Learning)