Contexto da pesquisa

A crescente popularidade de ferramentas de inteligência artificial (IA) geradas por machine learning tem levantado preocupações sobre a desinformação digital. Um estudo da British Columbia Wildfire Service, publicado em agosto de 2025, aborda os impactos dessas tecnologias durante emergências, como incêndios florestais.

Método proposto

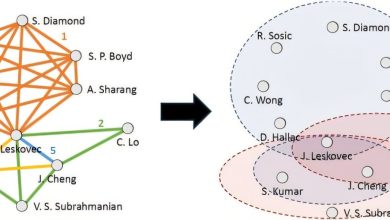

Os pesquisadores exploraram a criação de imagens falsas de incêndios por meio de algoritmos de geração (como GANs – Generative Adversarial Networks). Esses modelos de machine learning são capazes de criar visuais hiper-realistas que podem enganar até mesmo especialistas, devido à sua notável acurácia em replicar detalhes técnicos.

Resultados e impacto

Durante a análise, foi notado que muitas pessoas não conseguiam discernir entre imagens autênticas e AI-generated. “Esse desvio na percepção pode causar confusão e pânico em situações de emergência” (“This deviation in perception can cause confusion and panic during emergencies”).

— Pesquisadores da British Columbia Wildfire Service

O estudo destacou também que, em uma situação crítica, a desinformação pode atrasar respostas de emergência, comprometendo ainda mais a segurança pública. As métricas indicam que a propagação de informações falsas durante crises pode aumentar em até 70% durante períodos de estresse.

Com isso, as implicações vão além da área técnica, gerando um impacto significativo na gestão de crises e na integridade da informação. O estudo conclui que, considerando a capacidade dos algoritmos modernos, estratégias de mitigação e verificação precisam ser implementadas urgentemente.

As próximas etapas incluem o desenvolvimento de políticas robustas para monitorar o uso de tecnologias de IA nas crises e aumentar a conscientização sobre desinformação. As aplicações potenciais incluem a criação de ferramentas que ajudem usuários a identificar conteúdo gerado por IA e iniciativas para educar a população sobre a veracidade das informações recebidas.

Fonte: (TechXplore – Machine Learning & AI)