São Paulo — InkDesign News —

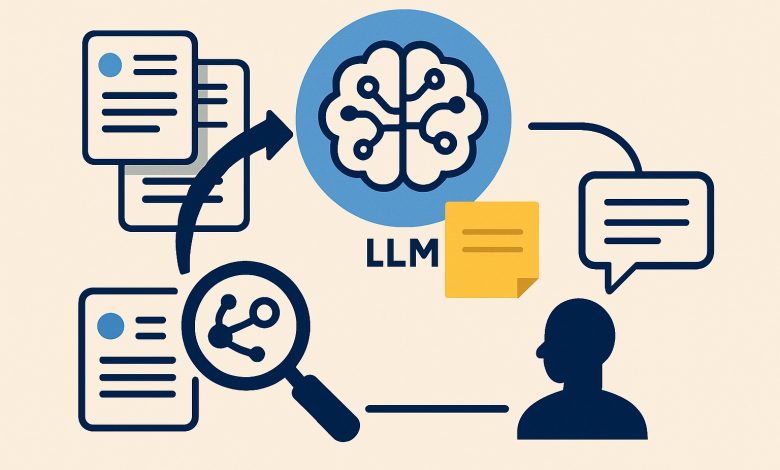

A aplicação de técnicas de “machine learning” está em ascensão, e novas abordagens de engenharia de contexto têm mostrado promissora efetividade na melhoria do desempenho de modelos de linguagem. O conceito de engenharia de contexto, que inclui a seleção otimizada de dados como “prompts” e exemplos, está revolucionando a forma como interagimos com LLMs (Modelos de Linguagem de Grande Escala).

Arquitetura de modelo

Os modelos de linguagem modernos, como o GPT e o BERT, são projetados para processar grandes volumes de dados. A engenharia de contexto é crucial aqui, pois implica decidir quais dados acessar para maximizar a performance do modelo. Elementos como o prompt do sistema e o uso de exemplos são determinantes.

Andrej Karpathy destacou a importância do conceito, afirmando: “Engenharia de contexto é a delicada arte e ciência de preencher a janela de contexto…” (“context engineering is the delicate art and science of filling the context window…”)— Andrej Karpathy, Pesquisador da OpenAI. Este enfoque permite criar sistemas que não apenas executam tarefas, mas que formam uma compreensão mais profunda a partir dos contextos fornecidos.

Treinamento e otimização

A otimização do contexto inclui técnicas como “zero-shot” e “few-shot prompting”. No zero-shot, o modelo tenta realizar uma tarefa sem exemplos prévios, enquanto o few-shot envolve o fornecimento de exemplos para melhorar a precisão. Essa diferença pode ser significativa, pois humanos também se saem melhor em tarefas quando recebem exemplos.

A construção de um prompt precisaria assegurar que a tarefa solicitada seja clara, por exemplo: “Você é um classificador de textos, e sua tarefa é classificar textos em classe A ou B. Classe A: Texto com sentimento positivo. Classe B: Texto com sentimento negativo” (“You are an expert text classifier, and tasked with classifying texts into class A or B. Class A: The text contains a positive sentiment. Class B: The next contains a negative sentiment”)— Expert Text Classifier, Modelo GPT. Essa estrutura permite que o modelo melhore seu desempenho ao entender melhor o que é esperado dele.

Resultados e métricas

O uso da técnica de RAG (Retrieval-Augmented Generation) permite que modelos recuperem informações relevantes de bases de dados extensas, realizando buscas vetoriais para encontrar documentos mais pertinentes à consulta. Isso otimiza a capacidade do modelo, contribuindo para uma geração de respostas mais precisa e contextualizada.

Os indicadores de desempenho ficam evidentes no aumento da acurácia nas tarefas. Com uma janela de contexto ampliada, os LLMs estão se mostrando cada vez mais eficientes na recuperação e geração de dados, mas a quantidade excessiva de informações pode levar ao fenômeno conhecido como “context rot”, que prejudica a performance de maneira inesperada. A gestão equilibrada desse contexto é crucial para garantir a eficácia das interações.

O futuro da engenharia de contexto aponta para a utilização ainda mais refinada dos dados, com a inclusão de ferramentas que ampliam o potencial do modelo. A aplicação de APIs para conectar LLMs com sistemas externos pode transformar a forma como consultamos informações em tempo real.

Fonte: (Towards Data Science – AI, ML & Deep Learning)