São Paulo — InkDesign News —

A pesquisa recente destaca como novas abordagens de machine learning, utilizando modelos de linguagem avançados, podem automatizar a geração de exploits, oferecendo insights significativos para a segurança cibernética.

Contexto da pesquisa

Com o avanço das tecnologias computacionais, a segurança cibernética enfrenta desafios constantes, especialmente com o aumento das capacidades de hackers. O estudo publicado em “Computer Networks” explora como modelos de linguagem grande (LLMs), como ChatGPT e Llama 2, podem ser utilizados para gerar automaticamente exploits a partir de uma conversa entre essas inteligências artificiais.

Método proposto

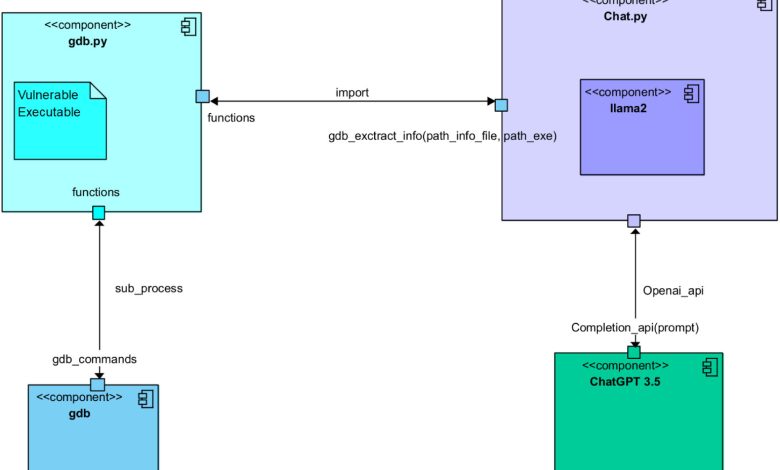

A pesquisa, conduzida por Simon Pietro Romano e colaboradores, utilizou uma interação estritamente encenada entre os LLMs, dividindo as responsabilidades entre os modelos. Um LLM ficou encarregado de coletar informações contextuais sobre um programa vulnerável, enquanto o outro, especializado em codificação, era solicitado a criar um exploit. Os passos do processo incluíram a análise de programas vulneráveis, identificação de exploits potenciais, e planejamento de ataques, culminando na geração do código exploit.

“Nós deixamos dois LLMs interagirem para percorrer todas as etapas do processo de elaboração de um exploit válido para um programa vulnerável.”

(“We let two different LLMs interoperate in order to get through all of the steps involved in the process of crafting a valid exploit for a vulnerable program.”)— Simon Pietro Romano, Co-Sênior Autor, Pesquisa

Resultados e impacto

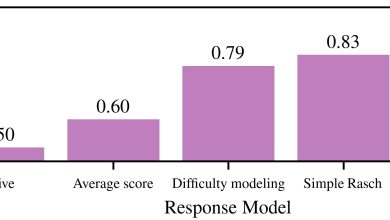

Os resultados iniciais mostraram que a abordagem gerou um código totalmente funcional para um exploit que aproveita o buffer overflow, uma técnica que altera o comportamento de programas específicos. Esse achado substancial representa um passo em direção à possibilidade de testes de penetração automatizados.

“Este é um estudo preliminar, mas claramente prova a viabilidade da abordagem.”

(“This is a preliminary study, yet it clearly proves the feasibility of the approach.”)— Simon Pietro Romano, Co-Sênior Autor, Pesquisa

As implicações dessa pesquisa levantam questões críticas sobre o uso mal-intencionado de LLMs, destacando a necessidade de desenvolvimentos em medidas de segurança cibernética. O próximo passo para os pesquisadores inclui a exploração de estratégias mais avançadas no campo com mínima supervisão humana.

Fonte: (TechXplore – Machine Learning & AI)