Deep learning ensina robôs bioinspirados a se mover com câmera

São Paulo — InkDesign News —

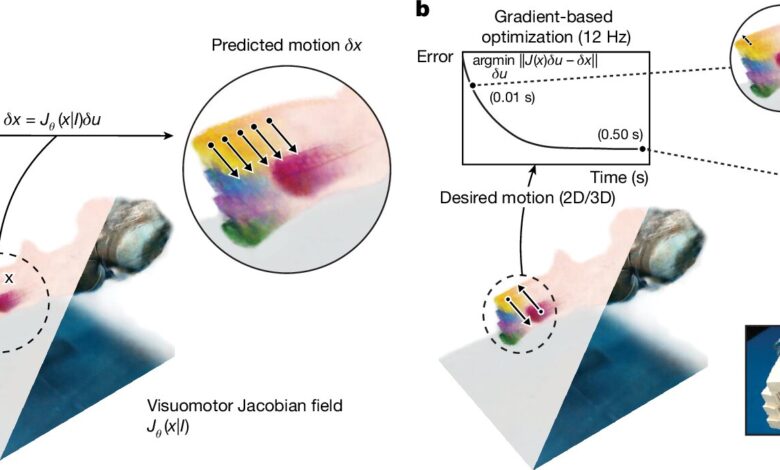

A pesquisa em machine learning está em plena expansão, especialmente no desenvolvimento de robôs bioinspirados que utilizam a visão de uma única câmera para se movimentar em ambientes complexos. Um estudo recente do MIT oferece uma nova abordagem nessa área, utilizando redes neurais para melhorar o controle desses robôs.

Contexto da pesquisa

Robôs convencionais, apesar de serem fáceis de modelar e controlar, apresentam rigidez que limita sua operação em espaços confinados e terrenos irregulares. Em contraste, robôs bioinspirados são projetados para serem mais flexíveis e adaptativos. Contudo, essas qualidades normalmente exigem um conjunto de sensores on-board e modelos espaciais personalizados.

Método proposto

A equipe de pesquisadores do MIT desenvolveu um sistema de controle baseado em deep learning que ensina robôs a seguir comandos a partir de uma única imagem. Eles treinaram uma rede neural profunda em vídeos multi-visão de robôs realizando comandos aleatórios durante duas a três horas. O modelo consegue reconstruir a forma e a mobilidade de um robô a partir de uma única captura. Esse método é mais acessível e não requer a customização que caracteriza versões anteriores.

“Nosso método liberta o design de hardware dos robôs de nossa capacidade de modelá-los manualmente”,

(“Our method unshackles the hardware design of robots from our ability to model them manually.”)— Sizhe Lester Li, Estudante de Doutorado, MIT

Resultados e impacto

Os testes mostraram que o sistema alcançou uma precisão inferior a três graus em movimento das juntas e menos de 4 milímetros (cerca de 0,15 polegadas) de erro no controle das extremidades. A abordagem também demonstrou capacidade de compensação em relação ao movimento do robô e mudanças no ambiente.

O sistema, que funciona apenas com visão, pode encontrar limitações em tarefas que exigem sensoriamento de toque e manipulação tátil. A adição de sensores táteis pode permitir que os robôs executem tarefas mais complexas. Além disso, existe o potencial para automatizar o controle de uma gama mais ampla de robôs, incluindo aqueles com poucos ou nenhum sensor embutido.

O futuro da robótica pode, assim, se direcionar para um modelo onde os robôs aprendem de forma autônoma a partir de demonstrações visuais, reduzindo a dependência de engenharia intensiva e programação.

Fonte: (TechXplore – Machine Learning & AI)