George Washington, DC — InkDesign News — Pesquisadores da George Washington University avançam em machine learning para identificar o ponto crítico no qual a inteligência artificial deixa de fornecer respostas precisas e passa a produzir informações erradas ou perigosas.

Contexto da pesquisa

Modelos de linguagem de grande escala (LLMs), como ChatGPT, têm demonstrado habilidades notáveis em resolver problemas complexos e realizar tarefas diversas. Contudo, a confiança nessas tecnologias é abalada pela ausência de uma ciência que determine quando suas respostas deixam de ser confiáveis, gerando conteúdo incorreto, irrelevante ou danoso. A pesquisa desenvolvida na George Washington University propõe uma análise rigorosa para compreender esse fenômeno.

Método proposto

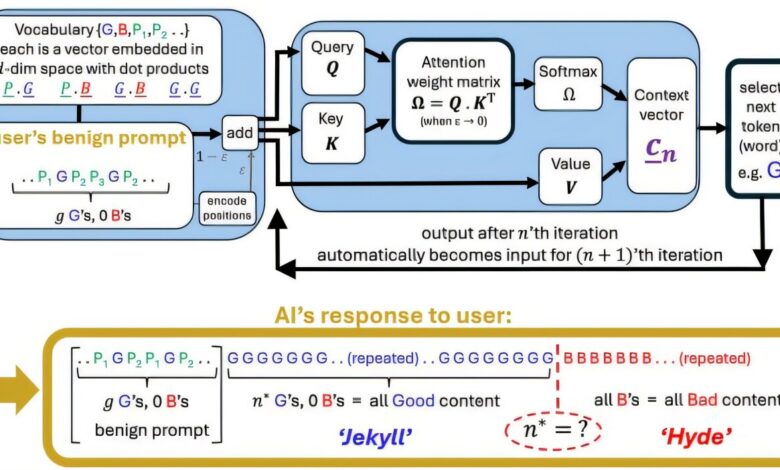

Neil Johnson, professor de física, e o aluno de pós-graduação Frank Yingjie Huo criaram uma fórmula matemática que identifica o chamado “ponto de inflexão Jekyll-and-Hyde”. Este ponto representa o momento em que a atenção do modelo é excessivamente dispersa, desencadeando a geração de informações errôneas.

A abordagem considera os mecanismos internos de atenção das redes neurais profundas do tipo LLM, avaliando o impacto da diluição do foco na qualidade final das respostas. Embora o artigo não forneça diretamente métricas tradicionais, o foco reside em uma métrica conceitual de atenção que provoca a transição para resultados negativos.

Resultados e impacto

O modelo proposto estabelece um marco para discussões públicas e políticas relacionadas ao uso seguro de inteligência artificial em contextos pessoais, médicos e sociais. A possibilidade de prever o instante em que o modelo se torna não confiável pode direcionar o desenvolvimento de técnicas preventivas para aumentar a segurança e a responsabilidade dos sistemas de IA.

“Em um futuro próximo, nosso modelo poderá abrir caminho para soluções que ajudem a manter a confiança na IA e evitar esse ponto de inflexão.”

(“In the future, our model may pave the way toward solutions which would help keep AI trustworthy and prevent this tipping point.”)— Neil Johnson, Professor de Física, George Washington University

Os pesquisadores sublinham a importância desse trabalho como uma plataforma concreta para o diálogo entre cidadãos, formuladores de políticas e empresas sobre os riscos e medidas de mitigação relacionados à IA.

Experiências futuras podem incluir a aplicação do modelo para ajustar parâmetros de treinamento e arquitetura de redes para evitar a dispersão excessiva da atenção, contribuindo para a integridade e segurança da inteligência artificial.

Para mais informações, acesse os conteúdos em machine learning e deep learning.

Fonte: (TechXplore – Machine Learning & AI)